在当今的人工智能领域,极速快三专家 陆兮类脑大模型因其卓越的性能和广泛的应用而备受瞩目。这类模型模拟人脑的工作方式,通过复杂的算法和庞大的数据集来处理和学习各种任务。然而,随着模型规模的不断扩大,其运算速度和资源占用成为了业界关注的焦点。

大发最权威正规↓下载

极速快三专家

本文将深入探讨陆兮类脑大模型的运算速度以及资源占用情况,为读者揭开这一神秘面纱。

首先,我们来了解一下陆兮类脑大模型的运算速度。这类模型的核心在于其深度学习和神经网络的架构,它们通过大量的参数和层级来模拟人脑的认知过程。运算速度通常取决于多个因素,包括硬件设备的性能、模型架构的优化以及算法的效率等。

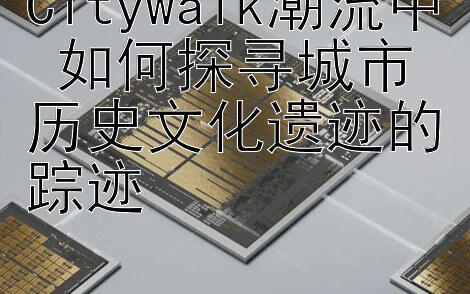

在硬件方面,现代的GPU(图形处理单元)和TPU(张量处理单元)等专用芯片为这类模型的快速运算提供了强大的支持。这些设备能够并行处理大量的矩阵运算,大幅度提升了模型的训练和推理速度。例如,使用最新的NVIDIA A100 GPU,陆兮类脑大模型的训练速度可以达到数千万甚至上亿次参数更新每秒。

然而,即便有强大硬件的支持,模型的规模和复杂性仍然对运算速度提出了挑战。为了解决这一问题,研究人员和工程师们不断优化模型架构,例如通过剪枝、量化和知识蒸馏等技术来减少模型的计算量和内存占用。此外,算法上的创新,如混合精度训练和高效的梯度累积策略,也在不断提升运算效率。

接下来,我们来看一下资源占用的情况。陆兮类脑大模型由于其庞大的参数数量和复杂的网络结构,通常需要大量的内存和存储资源。一个中型的类脑模型可能需要数十亿个参数,而大型模型则可能超过千亿甚至万亿个参数。这不仅对内存提出了极高的要求,也对存储和数据传输速度提出了挑战。

在进行模型训练和推理时,这些资源占用的压力尤为明显。训练过程中的数据加载、模型参数的更新和梯度的计算都需要大量的内存和计算资源。而在推理阶段,虽然计算量相对减少,但仍然需要足够的内存来加载模型参数,并处理输入数据。

为了应对这些挑战,业界采取了多种策略。一方面,通过硬件优化,如使用更高性能的存储设备和更快的内存技术,来减少资源占用和提高处理速度。另一方面,通过软件层面的优化,如模型压缩和高效的数据流管理,来提升资源利用率。此外,云计算和分布式计算的兴起也为大规模模型的训练和部署提供了新的解决方案。

总结来说,陆兮类脑大模型的运算速度和资源占用是衡量其性能和应用潜力的关键指标。通过不断的技术创新和优化,我们可以期待这些模型在未来能够更加高效地处理大规模数据,为人工智能的发展开辟新的篇章。